ctxt

CTXT -MARIO P.S.-Política / Comunicación Estados Unidos

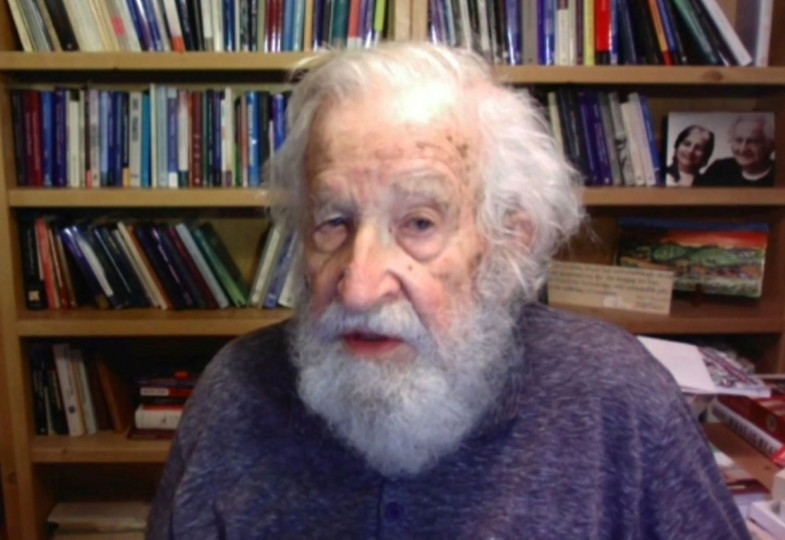

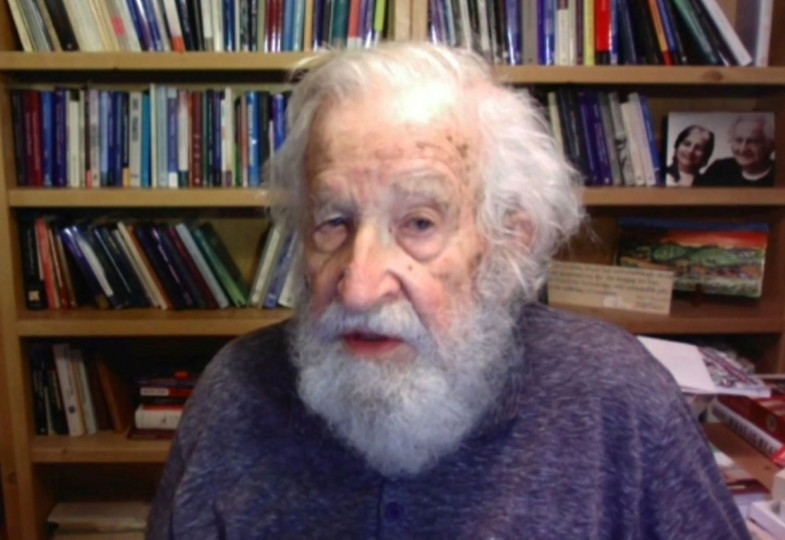

NOAM CHOMSKY / FILÓSOFO Y LINGÜISTA

“No creo que se puedan controlar las amenazas de la tecnología avanzada”

C. J. Polychroniou (Common Dreams) 20/05/2023

La Inteligencia Artificial (IA) se está expandiendo por el

mundo. Está transformando todos los ámbitos de la vida y,

en el proceso, plantea importantes cuestiones éticas para la

sociedad y el futuro de la humanidad. ChatGPT, que se está

haciendo con las redes sociales, es un chatbot de IA desarrollado por

OpenAI. Es un subconjunto de aprendizaje automático basado en lo

que se denomina modelos de lenguaje LLM, que generan respuestas

parecidas a las de un humano. No cabe duda de que las posibilidades de

aplicación de una tecnología como esta son enormes, por

eso ya se escuchan voces que piden la regulación de las IA tipo

ChatGPT.

¿Puede la IA burlar a los humanos? ¿Supone una amenaza

pública? Es más, ¿puede la IA convertirse en una

amenaza existencial? Noam Chomsky, el lingüista más

destacado del mundo y uno de los intelectuales públicos

más valorados de todos los tiempos, cuya talla intelectual se ha

comparado con la de Galileo, Newton y Descartes, aborda estas preguntas

incómodas en la siguiente entrevista.

Como disciplina científica, la inteligencia artificial (IA) se

remonta a la década de 1950, pero en los últimos veinte

años se ha ido abriendo paso en campos de todo tipo, como la

banca, los seguros, la industria automotriz, la música y la

defensa. De hecho, se ha demostrado que en algunos casos el uso de

técnicas de IA supera las habilidades humanas, como en el

ajedrez. ¿Cabe la posibilidad de que las máquinas lleguen

a ser más inteligentes que los humanos?

Por aclarar la terminología, cuando decimos

“máquina” nos referimos a un programa, es decir, una

teoría escrita en código que ejecuta un ordenador (una

teoría singular e interesante en muchos aspectos que no vamos a

comentar aquí).

A grandes rasgos, podemos diferenciar entre ingeniería pura y

ciencia. No existe una división clara, pero nos sirve para una

primera aproximación. La ingeniería pura busca la

elaboración de un producto que sea útil. La ciencia busca

entender. Si el tema es la inteligencia humana o las habilidades

cognitivas de otros organismos, la ciencia busca entender esos sistemas

biológicos.

Entiendo que los padres de la IA –Alan Turing, Herbert Simon y

Marvin Minsky, entre otros– la consideraban una ciencia, parte de

las entonces incipientes ciencias cognitivas, y se valían de las

nuevas tecnologías y los nuevos descubrimientos en la

teoría matemática de la computación para avanzar

en el entendimiento. A lo largo de los años, esa tendencia ha

ido desapareciendo y se ha visto desplazada en gran medida por el

enfoque de la ingeniería. Ahora, con cierta condescendencia, al

interés inicial se le suele tachar de simbólico (o GOFAI,

siglas de good old-fashioned AI, “IA a la antigua

usanza”).

Muchos organismos biológicos superan las habilidades cognitivas humanas en mayor profundidad

Volviendo a la pregunta, ¿cabe la posibilidad de que se

diseñen programas que superen las habilidades humanas? Debemos

tener cuidado con la palabra “habilidades”, por motivos que

daré más adelante. Pero si con el término nos

referimos a la actuación humana, la respuesta es un rotundo

sí. En realidad, llevan mucho tiempo existiendo, como la

calculadora en el ordenador, por ejemplo. Excede con creces lo que hace

un humano, aunque solo sea por falta de tiempo y de memoria. En el caso

de los sistemas cerrados como el ajedrez, quedó patente en los

cincuenta que, antes o después, con el avance de las ingentes

capacidades informáticas y un amplio periodo de

preparación, se podría diseñar un programa que

venciese a un Gran Maestro, que juega con un límite de memoria y

de tiempo. Lo que se consiguió unos años después

fue básicamente publicidad para IBM. Muchos organismos

biológicos superan las habilidades cognitivas humanas en mayor

profundidad. Las hormigas del desierto que hay en mi jardín

tienen un cerebro minúsculo, pero exceden en mucho la capacidad

de orientación humana, en general, no solo en cuanto a

actuación. No hay una Gran Cadena del Ser con los humanos en la

cúspide.

Los productos de la ingeniería de IA se están usando en

muchos campos, para bien o para mal. Hasta los más sencillos y

conocidos pueden ser muy útiles: en el campo del lenguaje, por

ejemplo, los programas de autorrelleno o de dictado o el traductor de

Google. Con capacidades informáticas mucho mayores y una

programación más sofisticada, debería haber

más aplicaciones útiles, también para la ciencia.

Ya hay algunas, como muestra el reciente caso del estudio del

plegamiento de proteínas, en el que la tecnología de

búsqueda rápida y a gran escala ha ayudado a los

científicos a lidiar con un problema crítico y

persistente.

Los proyectos de ingeniería pueden ser útiles o

perjudiciales. Ambas cuestiones se plantean también en el caso

de la ingeniería de IA. El trabajo actual con modelos de

lenguaje LLM, como los chatbots, ofrece herramientas para desinformar,

difamar y confundir a los que no tienen muchos datos. La amenaza es

mayor cuando se combinan con imágenes artificiales y

réplicas de voz. Con diversas preocupaciones en mente, decenas

de miles de investigadores de IA han solicitado recientemente una

moratoria en el desarrollo por los peligros potenciales que detectan.

Como siempre, las posibles ventajas de la tecnología tienen que sopesarse con los costes potenciales.

Las cuestiones que se plantean en cuanto a IA y ciencia son muy

diferentes. En este caso, hay que tener mucho cuidado con ciertas

afirmaciones descabelladas y desorbitadas, que los medios tienden a

amplificar. Para aclarar la cuestión, analicemos algunos casos,

unos hipotéticos y otros reales.

Antes he comentado la capacidad de orientación en los insectos,

algo asombroso. Los entomólogos han hecho grandes avances en el

estudio de su realización, pero la neurofisiología, una

materia complicadísima, sigue siendo esquiva, igual que la

evolución de los sistemas. Ocurre lo mismo con las

increíbles hazañas que protagonizan los pájaros y

las tortugas marinas, que tras viajar miles de kilómetros

regresan infaliblemente al punto de partida.

Las posibles ventajas de la tecnología tienen que sopesarse con los costes potenciales

Imaginemos que se presenta fulanito, partidario de la ingeniería

de IA, y dice: “Las conclusiones de tu trabajo han sido

rebatidas. Problema resuelto. Los pilotos de aerolíneas

comerciales logran los mismos resultados constantemente, incluso

mejores”.

Ni nos molestaríamos en contestar, nos entraría la risa.

Veamos el caso del arte de navegación de los polinesios,

aún vivo en las tribus indígenas, que usan las estrellas,

los vientos y las corrientes para dirigir sus canoas hasta un lugar en

concreto a cientos de kilómetros. También ha sido objeto

de muchas investigaciones para descubrir cómo lo hacen. Fulanito

tiene la respuesta: “Dejad de perder el tiempo, la flota naval lo

hace constantemente”.

Misma reacción.

Analicemos ahora un caso real, la adquisición del lenguaje. En

los últimos años ha sido objeto de investigaciones

exhaustivas y muy reveladoras, que demuestran que los niños

tienen un conocimiento muy amplio de la lengua (o lenguas) que habla su

entorno, mucho mayor de lo que ponen de manifiesto. Han logrado

demostrarlo con pocas pruebas, y en ocasiones cruciales, sin ninguna.

En el mejor de los casos, como muestran minuciosos estudios

estadísticos, los datos disponibles son escasos, sobre todo

cuando se tiene en cuenta el grado de frecuencia (“la ley de

Zipf”).

Entra fulanito en escena: “Queda rebatido. Sin tener en cuenta

vuestros descubrimientos, los LLM, que registran cantidades

desorbitantes de datos, encuentran regularidades estadísticas

que hacen posible simular los datos con los que se entrenan y producir

algo que se parece mucho al comportamiento normal humano. Los

chatbots”.

Este caso difiere de los anteriores. Primero, porque es real. Segundo,

porque a la gente no le entra la risa; de hecho, muchos están

impresionados. Y tercero, porque al contrario que los casos

hipotéticos, los resultados reales distan mucho de lo que se

afirma.

Estas consideraciones sacan a relucir un pequeño problema del

entusiasmo actual con los LLM: que son totalmente absurdos, como en los

casos hipotéticos, que se veía enseguida. Sin embargo,

hay problemas mucho más graves que el absurdo.

Uno de ellos es que los sistemas de LLM están diseñados

de tal manera que no nos dicen nada del lenguaje, del aprendizaje ni de

otros aspectos cognitivos, y es una cuestión de principio,

irremediable. Aunque dupliquemos los terabytes de datos registrados,

añadamos unos millones de parámetros más y

utilicemos todavía más energía de California, la

simulación de comportamiento mejorará, pero al mismo

tiempo, revelará con mayor claridad el fracaso de principio de

un enfoque que no busca ningún tipo de entendimiento. La

razón es evidente: los sistemas funcionan igual de bien con

lenguas imposibles de aprender que con las que los niños

adquieren rápido y casi instintivamente.

Es como si un biólogo dijera: “Se me ha ocurrido una nueva

teoría buenísima sobre los organismos. Incluye muchos que

existen y muchos que es imposible que existan, y no hay forma de

diferenciarlos”.

De nuevo, nos entraría la risa. O debería.

Ya no es solo fulanito, estamos hablando de casos reales. Insistiendo

en apartarse radicalmente de la ciencia, fulanito contesta:

“¿Cómo lo sabes si no has investigado todas las

lenguas?”. Llegados a este punto, el abandono de la ciencia

normal se hace aún más patente. Por el mismo

razonamiento, podemos deshacernos de la genética y la

biología molecular, de la teoría de la evolución y

del resto de ciencias biológicas, que no han analizado

más que una ínfima parte de los organismos. Y por si

acaso, también desterramos toda la física. ¿Por

qué íbamos a creer en las leyes del movimiento de Newton?

¿Cuántos objetos se han observado de verdad en movimiento?

Por otro lado, está el ligero detalle de la carga probatoria.

Los que plantean una teoría tienen la responsabilidad de

demostrar que tiene sentido demostrando que no funciona con lenguas

imposibles. No es responsabilidad de los demás rebatir el

planteamiento, aunque en este caso parece bastante fácil hacerlo.

Prestemos atención ahora a la ciencia normal, donde los detalles

cobran interés. Hasta un único ejemplo de

adquisición del lenguaje puede ofrecer la oportunidad de

entender mejor la diferencia entre lenguas posibles e imposibles.

Las razones están claras y son bien conocidas. Todo crecimiento

y desarrollo, incluido el denominado “aprendizaje”, es un

proceso que comienza con un estado del organismo y lo va transformando

paso a paso en fases posteriores.

Es un principio establecido que la facultad del

lenguaje tiene propiedades básicas específicas de los

humanos

La adquisición del lenguaje es un proceso de este tipo. El

estado inicial es el legado biológico de la facultad del

lenguaje, que está claro que existe, aunque sea, como creen

algunos, una combinación particular de otras capacidades. Es muy

poco probable que sea así por motivos que hace mucho que

quedaron claros y que no voy a explicar porque no son relevantes en lo

que nos ocupa. Es obvio que hay un legado biológico en la

facultad humana del lenguaje. Un mero axioma.

La transición da lugar a un estado relativamente estable,

modificado solo en apariencia: el conocimiento de la lengua. Los datos

externos desencadenan y configuran en parte el proceso. Mediante el

estudio del estado alcanzado (el conocimiento de la lengua) y de los

datos externos, podemos sacar conclusiones trascendentales sobre el

estado inicial, el legado biológico que hace posible la

adquisición del lenguaje. Las conclusiones sobre el estado

inicial determinan la diferencia entre lenguas posibles e imposibles. Y

esta diferencia es aplicable a todos aquellos que comparten el estado

inicial, es decir, a todos los humanos, que se sepa, pues no parece que

haya diferencia en la capacidad de adquisición del lenguaje

entre los grupos humanos existentes.

Todo esto es ciencia normal y ha logrado muchos resultados.

Los experimentos demuestran que el estado estable se obtiene en buena

parte muy pronto, hacia los tres o cuatro años. También

es un principio establecido que la facultad del lenguaje tiene

propiedades básicas específicas de los humanos, por lo

que es una auténtica propiedad de la especie: es común a

todos los grupos humanos y, en lo fundamental, un atributo humano

único.

Hay mucho que se queda fuera de esta explicación

esquemática, sobre todo el papel de las leyes naturales en el

crecimiento y el desarrollo, y en el caso de un sistema computacional

como el lenguaje, los principios de eficiencia computacional. Pero

ahí está el quid de la cuestión. Repito: es

ciencia normal.

Es importante dejar claro la distinción de Aristóteles

entre posesión de conocimiento y uso de conocimiento (en

términos modernos, competencia y actuación). En el caso

del lenguaje, el estado estable que se obtiene es posesión de

conocimiento, codificado en el cerebro. El sistema interno establece

una variedad ilimitada de expresiones estructuradas, cada una de las

cuales podemos considerar que plantea un pensamiento, cada uno de ellos

externalizable mediante algún sistema sensoriomotor, normalmente

el sonido, aunque podría ser un gesto o incluso (no sin

dificultad) el tacto.

Si queremos entender qué tipo de criaturas

somos, lo primero que debería interesarnos es lo que hace de los

humanos la especie más única de todas

Al sistema codificado internamente se accede mediante el uso del

conocimiento (la actuación). La actuación incluye el uso

interno del lenguaje en el pensamiento: la reflexión, el

planteamiento, los recuerdos y muchísimas cosas más.

Desde el punto de vista estadístico, es por goleada el uso

predominante del lenguaje. Es inaccesible a la introspección,

aunque podemos aprender mucho sobre él con los métodos

normales de la ciencia, desde “fuera”,

metafóricamente hablando. Lo que llamamos “diálogo

interior” en realidad son fragmentos de lenguaje externalizado

con el aparato articulatorio en silencio. No es más que un

reflejo remoto del uso interno del lenguaje, otro aspecto importante en

el que no me voy a extender aquí.

Otras formas del uso del lenguaje son la percepción (el

análisis sintáctico) y la producción. Esta

última entraña propiedades que hoy siguen siendo un

misterio, igual que lo eran cuando Galileo y sus contemporáneos

las observaban con admiración en los albores de la ciencia

moderna.

El objetivo principal de la ciencia es descubrir el sistema interno,

tanto en el estado inicial de la facultad humana del lenguaje como en

las formas específicas que adopta en la adquisición. En

la medida en que conozcamos el sistema interno, podemos proceder a

investigar cómo entra en actuación e interacciona con

otros muchos factores que entran en el uso del lenguaje.

Los datos de la actuación ofrecen pruebas sobre la naturaleza

del sistema interno, especialmente cuando los experimentos los hacen

más precisos, como es habitual en el trabajo de campo. Pero

hasta la recolección de datos más exhaustiva induce

necesariamente a error en aspectos cruciales. Se atiene a lo que se

produce normalmente, no al conocimiento del lenguaje codificado en el

cerebro, objeto principal de investigación para los que quieren

entender la naturaleza del lenguaje y su uso. Ese objeto interno

establece infinitas posibilidades más de las que se

usarían en un comportamiento normal por factores irrelevantes al

lenguaje, como las limitaciones de la memoria a corto plazo, temas que

se estudiaron hace sesenta años. Los datos observados

también incluyen gran parte de lo que se queda fuera del sistema

codificado en el cerebro, que suelen ser usos conscientes del lenguaje

que incumplen las normas de los propósitos retóricos. Son

axiomas que conocen todos los que realizan trabajo de campo, que

dependen de técnicas de obtención de información

con los voluntarios, básicamente experimentos, para generar un

corpus mejorado que excluya restricciones irrelevantes y expresiones

anómalas. Ocurre lo mismo cuando los lingüistas se usan a

sí mismos como voluntarios, un procedimiento perfectamente

normal y adecuado, habitual en la historia de la psicología

hasta el día de hoy.

Lo que ofrece verdaderas pistas acerca de lo que nos hace únicos es lo que no es rutina

Si seguimos avanzando con la ciencia normal, descubrimos que los

procesos internos y los elementos del lenguaje no pueden detectarse

mediante la inspección de fenómenos observados.

Normalmente estos elementos ni siquiera aparecen en el discurso (oral o

escrito), aunque sus efectos, que suelen ser sutiles, sí se

pueden detectar. Esto supone otro motivo más por el que

restringirse a los fenómenos observados, como en los enfoques de

LLM, limita drásticamente el entendimiento de los procesos

internos que son el objeto principal de la investigación en la

naturaleza del lenguaje, su adquisición y su uso. Sin embargo,

nada de esto es relevante si el interés por la ciencia y el

entendimiento se han abandonado en favor de otras metas.

En líneas más generales, la ciencia, durante miles de

años, ha llegado a conclusiones a través de experimentos

–normalmente experimentos mentales–, una abstracción

radical del fenómeno. Los experimentos están basados en

la teoría y buscan descartar los innumerables factores

irrelevantes que entran en la observación de los

fenómenos, como la actuación lingüística.

Todo esto es tan básico que ni se discute. Se sabe. Como ya he

comentado, la distinción básica se remonta a la de

Aristóteles entre posesión y uso del conocimiento. La

primera es el objeto central de estudio. Los estudios secundarios (muy

importantes) investigan cómo se usa el sistema almacenado

internamente en la actuación, junto con la multitud de factores

no lingüísticos que entran en lo que se observa

directamente.

Recordemos una observación del biólogo evolutivo

Theodosius Dobzhansky, conocido principalmente por su trabajo con

Drosophila: todas las especies son únicas, y la humana es la

más única de todas. Si queremos entender qué tipo

de criaturas somos –obedeciendo el mandato del Oráculo de

Delfos de hace 2.500 años–, lo primero que debería

interesarnos es lo que hace de los humanos la especie más

única de todas, en especial el lenguaje y el pensamiento,

estrechamente interconectados, como queda reflejado en la rica

tradición que se remonta a la Grecia clásica y a la

India. La mayor parte del comportamiento es bastante rutinario, y por

lo tanto, hasta cierto punto predecible. Lo que ofrece verdaderas

pistas acerca de lo que nos hace únicos es lo que no es rutina,

y eso lo encontramos, unas veces mediante experimentos y otras mediante

observación, tanto en niños normales como en grandes

artistas y científicos.

La sociedad lleva un siglo plagada de intensas

campañas corporativas que fomentan el desprecio por la ciencia

Un último comentario al respecto. La sociedad lleva un siglo

plagada de intensas campañas corporativas que fomentan el

desprecio por la ciencia, un tema que Naomi Oreskes, entre otros, ha

estudiado bien. Todo empezó con corporaciones cuyos productos

eran nocivos para la salud: plomo, tabaco, amianto y después

combustibles fósiles. Sus motivaciones son comprensibles. El

objetivo de un negocio en una sociedad capitalista es ganar dinero, no

el bienestar de las personas. Es un hecho institucional: si no entras

en el juego, estás fuera y alguien que sí lo haga

vendrá a reemplazarte.

Los departamentos de relaciones públicas de las corporaciones

enseguida se dieron cuenta de que sería un error negar las

pruebas científicas que se iban acumulando de los efectos

letales de sus productos. Sería fácil de rebatir. Era

mejor sembrar la duda, alentar la incertidumbre, menospreciar a esos

trajeados que nunca han pintado una casa pero vienen de Washington a

decirme que no use pintura con plomo y destruyen mi negocio (caso real,

perfectamente extrapolable). Ha funcionado demasiado bien. Ahora mismo

nos está llevando por el camino de la destrucción de la

vida humana organizada en la Tierra.

En algunos círculos intelectuales, la crítica posmoderna

de la ciencia, que Jean Bricmont y Alan Sokal se encargaron de

desmontar pero que sigue viva en ciertos ambientes, ha producido

efectos similares.

Quizá sea incómodo plantearlo, pero creo que es razonable

preguntarse si los fulanitos y los que repiten sin pensar e incluso

amplifican sus negligentes proclamas están contribuyendo a las

mismas tendencias siniestras.

Es posible que los proyectos de ingeniería futura incluso superen las habilidades humanas

ChatGPT es un chatbot basado en lenguaje natural que usa la

inteligencia artificial para entablar conversaciones similares a las

humanas. En un artículo reciente en The New York Times, junto

con otros dos autores, usted calificaba los nuevos chatbots de

despliegue publicitario porque sencillamente no están al mismo

nivel que la competencia lingüística de los humanos. Sin

embargo, ¿no es posible que innovaciones futuras en IA generen

proyectos de ingeniería que sí estén al mismo

nivel y que incluso lleguen a superar las habilidades humanas?

El mérito del artículo debemos atribuírselo a su

verdadero autor, Jeffrey Watumull, excelente matemático,

lingüista y filósofo. Los dos coautores éramos

asesores que estuvimos de acuerdo con el artículo, pero no lo

escribimos.

Es verdad que los chatbots en principio no están al mismo nivel

de competencia lingüística que los humanos, por los motivos

indicados anteriormente. Su diseño básico les impide

alcanzar la condición mínima de adecuación para

una teoría del lenguaje humano: distinguir entre lenguas

posibles e imposibles. Como es una propiedad del diseño, no

puede salvarse con innovaciones futuras en este tipo de IA. Sin

embargo, es muy probable que los proyectos de ingeniería futura

lleguen al mismo nivel e incluso superen las habilidades humanas, si

nos referimos a la capacidad humana de actuar, a la actuación.

Como ya se ha comentado, algunas llevan tiempo haciéndolo: las

calculadoras automáticas, por ejemplo. Es más

interesante, como indicaba, que haya insectos con el cerebro

minúsculo que superan las habilidades humanas entendidas como

competencia.

A menos que se controle con cuidado, la ingeniería de IA puede representar serias amenazas

En el artículo mencionado, también se observaba que los

proyectos actuales de IA no tienen facultad moral humana. ¿Esta

obviedad hace que los robots de IA supongan una amenaza menor para la

raza humana? Creo que se puede argumentar que los convierte en una

amenaza aún mayor.

Es una obviedad, desde luego, si entendemos la “facultad

moral” en su sentido más amplio. A menos que se controle

con cuidado, la ingeniería de IA puede representar serias

amenazas. Supongamos, por ejemplo, que el cuidado de pacientes

estuviera automatizado. Los errores inevitables que el juicio humano

solucionaría podrían provocar una historia de terror. O

imaginemos que apartamos a los humanos de la evaluación de

amenazas determinadas por los sistemas automatizados de defensa

antimisiles. Como nos indica un documento histórico

estremecedor, sería el final de la civilización humana.

A los organismos reguladores y las fuerzas del orden en Europa les

preocupa la expansión de ChatGPT y acaba de presentarse un

instrumento legislativo de la Unión Europea que trata de lidiar

con la IA mediante la clasificación de dichas herramientas de

acuerdo con el nivel de riesgo que entrañen. ¿Está

de acuerdo con los que consideran que ChatGPT supone una amenaza

pública grave? Por otra parte, ¿cree realmente que el

futuro desarrollo de herramientas de IA puede detenerse hasta

introducir salvaguardias?

Comprendo perfectamente los esfuerzos de quienes intentan controlar las

amenazas que supone la tecnología avanzada, también en

este caso. Sin embargo, soy escéptico acerca de la posibilidad

de llevarlo a cabo. Me temo que la caja de Pandora ya está

abierta. Los actores maliciosos –institucionales o

particulares– seguramente encuentren las vías para eludir

las salvaguardias. Aunque estos temores, por supuesto, no son motivo

para no intentarlo ni para bajar la guardia.

--------------------------

Este artículo fue publicado originalmente en Common Dreams.

Traducción de Ana González Hortelano.